🎀 해당 게시물은 국민대학교 김장호 교수님의 '컴퓨터비전' 강의를 수강하며 정리한 글입니다. 🎀

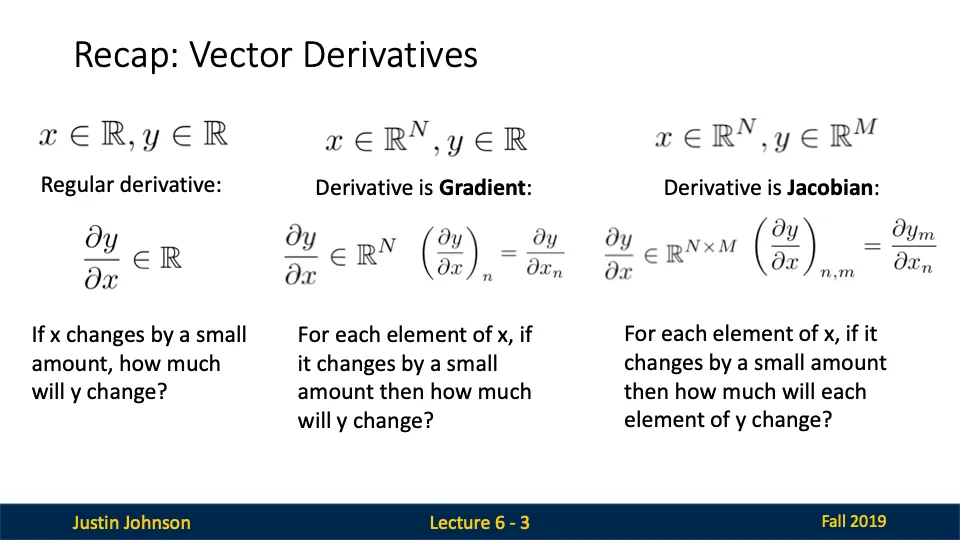

벡터 미분의 개념

- Regular Derivative: 스칼라 입력 x가 변화하면 출력 y가 얼마나 변화하는지.

- Gradient: 벡터 x의 각 요소가 변할 때 y가 얼마나 변화하는지.

- Jacobian: x의 각 요소 변화가 y의 모든 요소에 어떤 영향을 미치는지 나타내는 행렬.

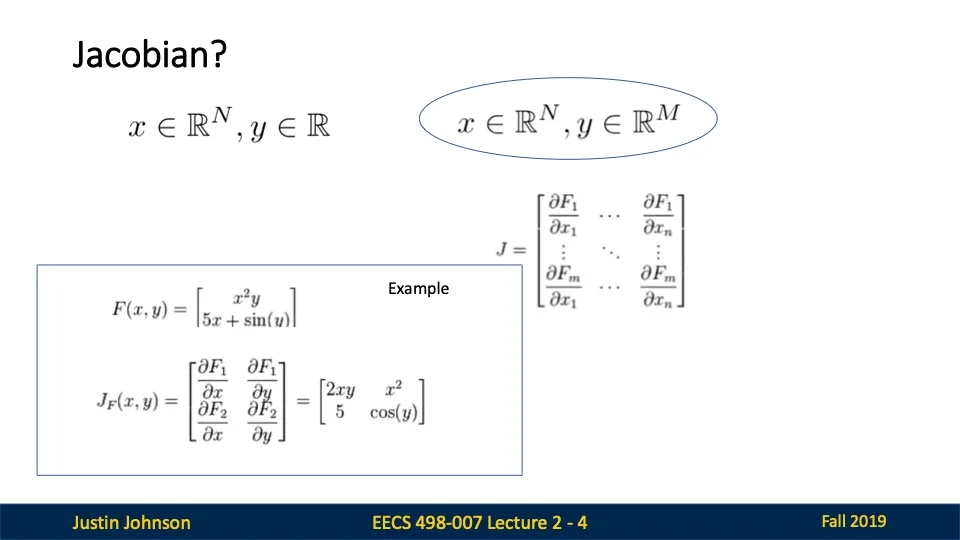

Jacobian 행렬

Jacobian 행렬은 벡터 함수의 각 구성 요소에 대해 모든 입력 변수에 대한 편미분을 포함하는 행렬이다.

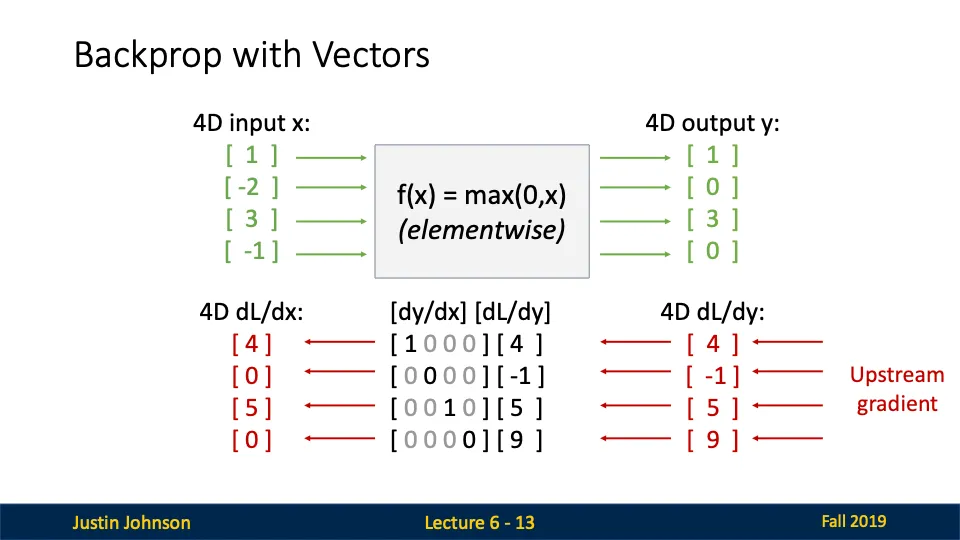

벡터 기반 역전파

이전 글에서 봣던 거랑 똑같음!

Upstream Gradient * Local Gradient = Downsteam Gradient

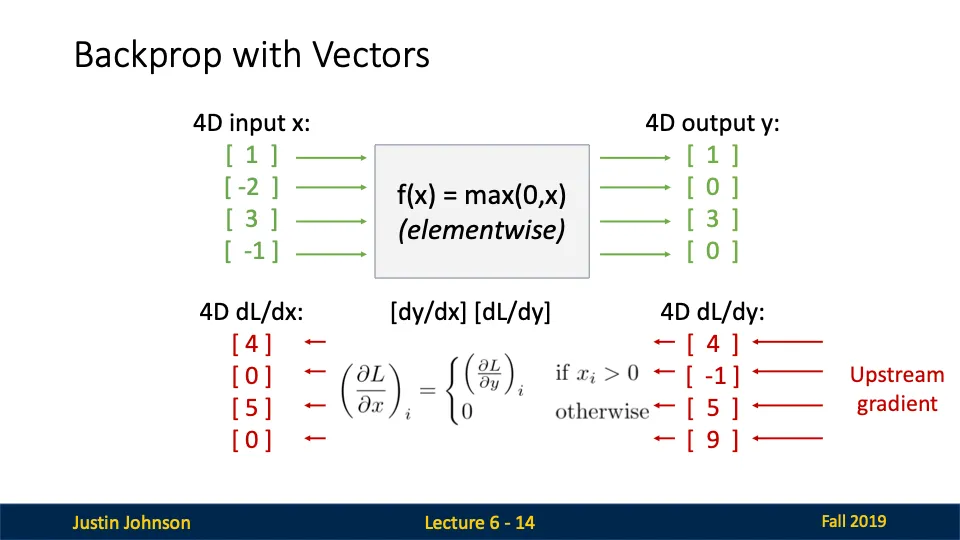

벡터화된 역전파

- 문제를 풀게 될 경우, 업스트림 그래디언트는 주어질 거임! 나는 중간 계산만 할 줄 알면 되는구야,,

- ReLU를 미분해서 로컬 그래디언트 행렬을 만들어주어요

- 업스트림과 로컬을 곱하면 다운스트림 그래디언트를 구할 수 있다!

문제가 굉장히 복잡해 보였지만 사실 그냥 전치행렬을 곱해주면 되는 것이엇다….!

'Computer Vision' 카테고리의 다른 글

| [컴퓨터비전] Convolutional Networks (0) | 2024.12.22 |

|---|---|

| [컴퓨터비전] Backpropagation (2) | 2024.12.20 |

| [컴퓨터비전] Regularization (1) | 2024.12.19 |

| [컴퓨터비전] DNN(Deep Neural Network) (0) | 2024.12.19 |

| [컴퓨터비전] Linear Classifiers (0) | 2024.12.19 |